فهرست مطالب

مسیر یادگیری خود را انتخاب کنید

مقدمات و مساله Bandit

مقدمه

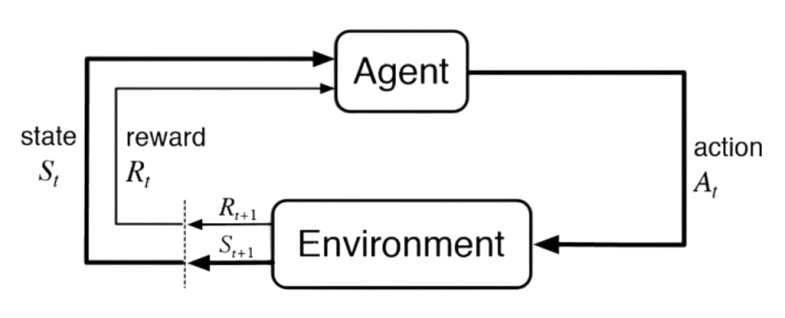

- اصلا RL چیه؟

- اجزای اصلی چیا هستن؟

- چند مثال برای درک بهتر.

مساله Multi-armed bandit ساده

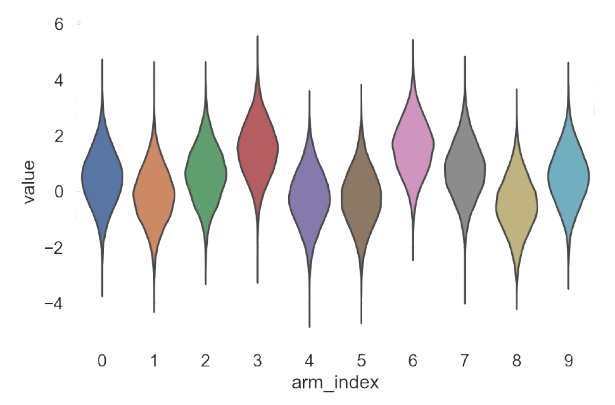

- مساله k-armed Bandit رو توضیح بدیم؟

- پیاده سازی Incremental.

- اکسپلور یا اکسپلویت؟ کدومش؟

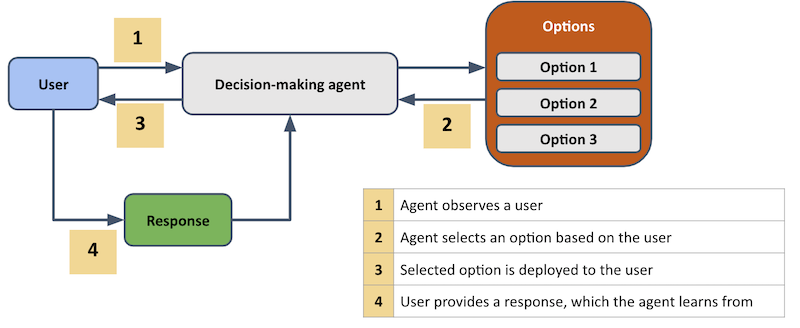

مساله Contextual Multi-armed Bandit

- حل مساله Bandit با استفاده از کانتکست

- LinUCB و مقایسه با UCB

- کاربردهای دنیای واقعی

مقدمات ریاضی

مفاهیم اساسی احتمال برای RL

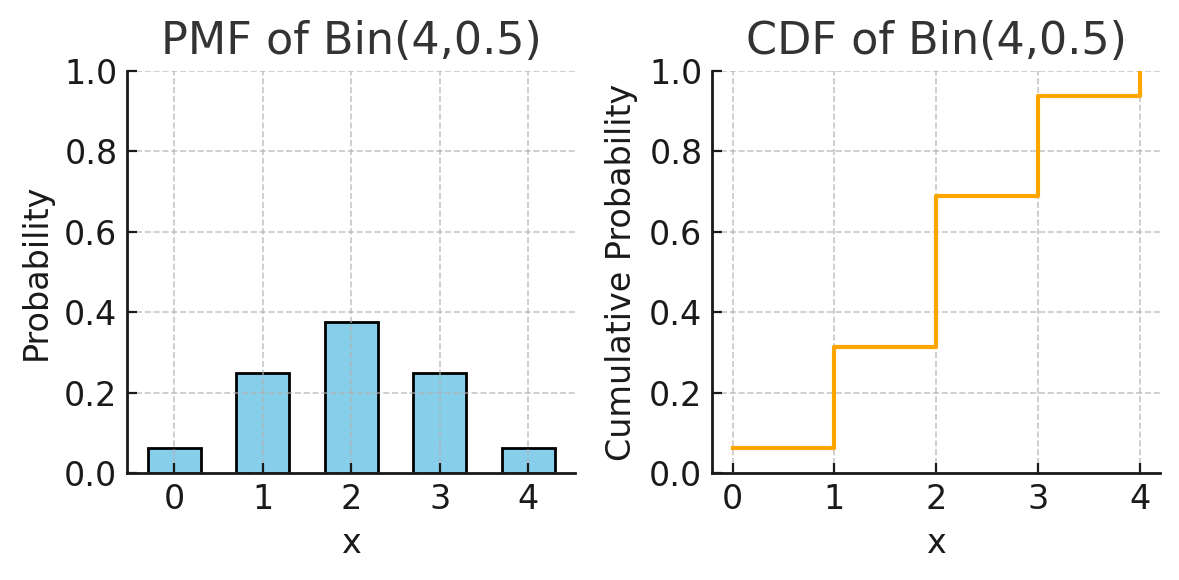

- متغیرهای تصادفی و توزیعهای احتمال

- امید ریاضی و واریانس

- فرآیندهای تصمیمگیری مارکوف

مقدمات MDP

- مفاهیم اساسی MDP

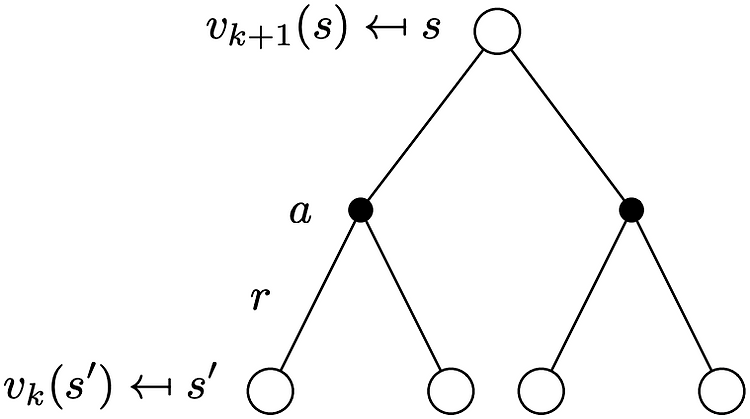

- معادلات Bellman

- Dynamic programming

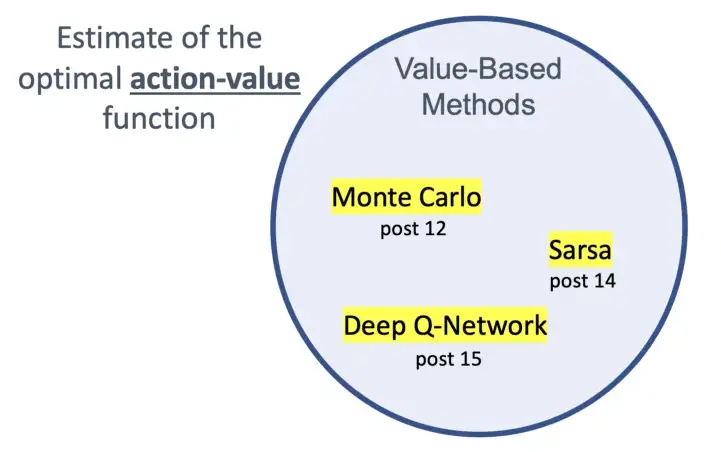

روش های Value-Based

تعریف معادله بلمن و dynamic programming

- value function و اهمیت آن

- معادلات بلمن

- Value Iteration، Q-Learning و سایر الگوریتمها

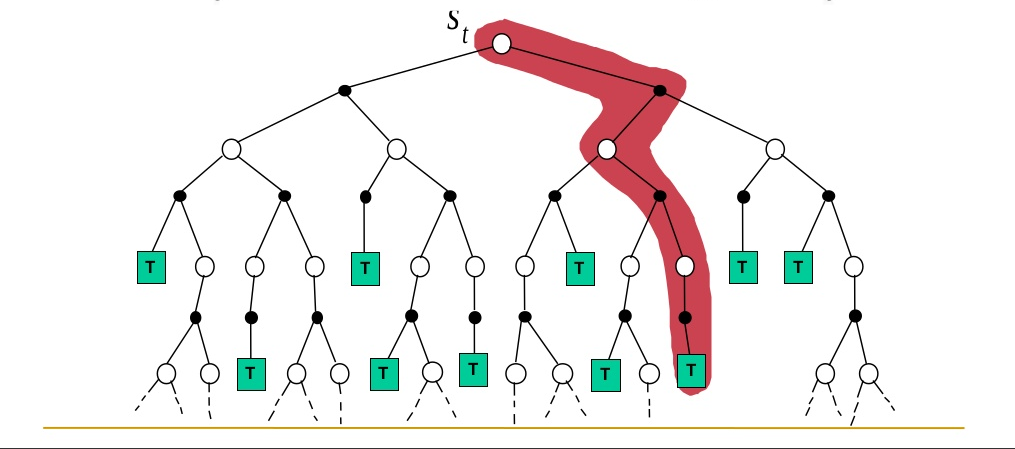

روشهای Monte Carlo

- Planning vs. Learning

- تعریف روش مونت کارلو

- نمونهبرداری تصادفی از اپیزودها